흑인 두명 사진 ‘고릴라’ 인식

성·인종차별 사회혼란 위험성

‘AI 검증하는 AI’ 필요성 커져

김윤 센터장 ‘ATDC 2018’ 발표

#의료계에 종사하는 두 명의 남녀가 있다. 인공지능(AI)은 이들의 직업을 어떻게 인지할까? AI는 이들의 성별 정보를 통해 남자는 의사, 여자는 간호사라는 결과물을 내놓는다. 성 역할에 대한 고정관념이 깔린 데이터가 쌓이고 쌓여 AI에 입력돼 온 탓이다.

편견을 가진 AI의 탄생을 막기 위해, 데이터 검증의 중요성이 갈수록 커지고 있다.

|

| 김윤 SK텔레콤 AI리서치 센터장이 지난 3일 서울 삼성동 그랜드 인터컨티넨탈 서울 파르나스에서 열린 SK텔레콤의 ‘ATDC(All Things Data Conference) 2018’에서 AI에 대해 발표하고 있다. |

김윤 SK텔레콤 AI리서치 센터장은 지난 3일 서울 삼성동 그랜드 인터컨티넨탈 서울 파르나스에서 열린 SK텔레콤의 ‘ATDC(All Things Data Conference) 2018’에서 “편견(Bias)을 가진 데이터는 인종차별, 성 차별을 하는 AI를 만들어 낼 공산이 크다”며 데이터 검증의 필요성을 역설했다.

그는 AI의 편견은 상상 이상의 사회혼란을 초래할 수 있다고 경고했다. 대표적인 것이 지난 2015년 구글 포토스의 사례다.

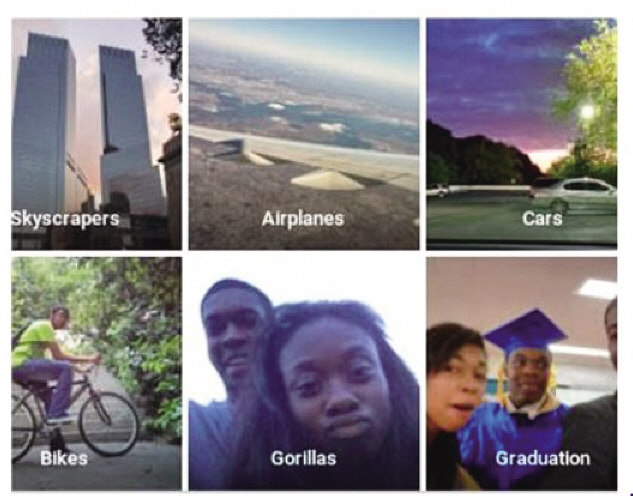

AI 기술을 통해 얼굴을 인식하고 사진을 분류하는 구글 포토스는 당시 흑인 두 명의 사진을 ‘고릴라’로 인식하는 오류를 야기했다.

AI가 검은 피부색을 사람으로 인지하지 못하면서 발생한 오류다.

구글은 즉각적으로 사과 성명서를 내고 피부색이 짙은 얼굴에 대한 자동 인식 알고리즘을 개선하겠다고 밝힌 바 있다.

|

| 지난 2015년 구글 포토스가 흑인 두 명의 사진을 ‘고릴라’로 인식해 논란이 됐다. [제공=데일리메일] |

김 센터장은 “구글 사태를 계기로 AI의 데이터 실수를 어떻게 줄일 수 있을까에 대한 연구가 활발해졌다”며 “AI의 편견은 인종, 정치 성향 등에 따라 사회적으로도 크게 논란이 될 수 있어 데이터의 편견을 조심해야 한다”고 강조했다.

특히 국내도 이같은 AI 편견에 따른 오류에서부터 자유로울 수 없는 구조라고 봤다.

그는 “한국도 지역마다 다양한 사투리가 있고 향후 북한 사투리까지 가세할 경우 음성, 말투에 따라 AI의 편견이 발생할 여지가 있다”며 “예전보다 더욱 방대해진 음성 데이터를 효과적으로 구성해 자연어 처리를 할 수 기술이 중요해 진 것”이라고 말했다.

AI의 ‘건강한’ 아웃풋(OUT-PUT)을 도출하기 위해, 인풋(IN-PUT) 데이터의 조건으로 크게 ▷타당성(relevance) ▷다양성(diversity) ▷질(quality) ▷양(quantity) 을 꼽았다.그는 “멀리서도 음성을 알아들어야 하는 AI스피커를, 가까운 곳에서 들리는 음성으로만 훈련하고 상용화시키면 그 데이터의 타당성이 떨어지는 것”이라며 “다양한 인종, 다양한 사투리 등 다양성을 가진 데이터를 확보하는 것도 중요하다”고 말했다. 이어 “좋은 질과 많은 양의 데이터는 가장 기본”이라고 덧붙였다.

이 같은 설명은 이른바 ‘착한 AI’를 위해 AI를 검증하는 AI가 필요하다는 최근 IT업계의 목소리와도 일맥상통한다.

IT업계에서는 AI에 입력하는 데이터가 적절한지, AI의 결과물이 적절한지에 대한 검증의 필요성이 커지면서 설명가능 인공지능(XAI, Explainable AI)이 최근 새롭게 주목받고 있는 추세다. XAI는 AI가 왜 이같은 결과를 도출했는지를 설명하는 기술로, AI를 검증하는 또다른 AI인 셈이다.

IT서비스업계 관계자는 “향후 해킹 등으로 의도적으로 부적절한 데이터를 AI에 입력하는 위협도 발생할 여지가 있다”며 “AI에 입력되는 데이터와 결과 데이터의 적절성을 자동으로 평가할 수 있는 기술 연구가 더욱 필요하다”고 말했다.

박세정 기자/sjpark@heraldcorp.com