가려지는 물체 뒷면도 복원…로봇 제어 등 분야 활용 기대

|

| 단일 영상만으로도 복잡한 손-물체 상호작용을 정확하게 복원하는 기술을 개발한 UNIST 백승렬 교수(왼쪽)와 온정완 연구원(오른쪽) [UNIST 제공] |

[헤럴드경제(울산)=박동순 기자] 모의수술 장면을 3차원(3D)으로 정확하게 구현할 수 있는 인공지능(AI) 기술이 개발돼 수술 시뮬레이션뿐만 아니라 상호작용 기반의 가상현실 콘텐츠 제작, 원격 로봇 제어 등 다양한 산업 분야에 적용될 수 있을 것으로 기대된다.

울산과학기술원(UNIST) 인공지능대학원 백승렬 교수팀은 3원색 RGB 영상만으로 양손과 기구의 복잡한 상호작용을 실시간 3D로 시각화할 수 있는 인공지능 모델 ‘BIGS(Bimanual Interaction 3D Gaussian Splatting)’를 개발했다고 9일 밝혔다.

AI는 카메라로 촬영된 2D 데이터만 받기 때문에 손과 물체의 실제 위치나 입체적인 형태를 파악하려면 이를 3차원으로 다시 복원하는 과정이 필요하다. 기존 기술은 한 손만 인식하거나 사전에 스캔 된 물체에만 대응할 수 있어 AR(증강현실)이나 VR(가상현실) 기술에서 현실감 있는 상호작용 장면을 재현해내는 데 있어서 한계가 있었다.

연구팀이 개발한 BIGS는 손이 가려지거나 일부만 보이는 상황에서도 전체 형상을 안정적으로 예측할 수 있으며, 처음 보는 물체도 학습된 시각 정보를 통해 보이지 않는 부분까지 자연스럽게 그려낼 수 있다.

이 AI 모델은 3차원 가우시안 스플래팅(Gaussaina Splatting)을 기반으로 한다. 가우시안 스플래팅은 사물의 형상을 퍼지는 점 구름 형태로 표현하는 방식으로, 손과 물체가 만나는 접촉면 등을 자연스럽게 복원할 수 있다.

이 방식은 손이 겹치거나 일부가 가려진 상황에서 전체 형상을 추정하기 어려웠는데, 모든 손을 하나의 기준 손 구조(Canonical Gaussian)에 맞춰 정렬하는 방식을 이용해 문제를 해결했다. 또 사전 학습된 확산모델을 활용한 점수 증류 방식(Score Distillation Sampling, SDS)으로 영상에 보이지 않는 물체의 뒷면까지 복원해냈다.

|

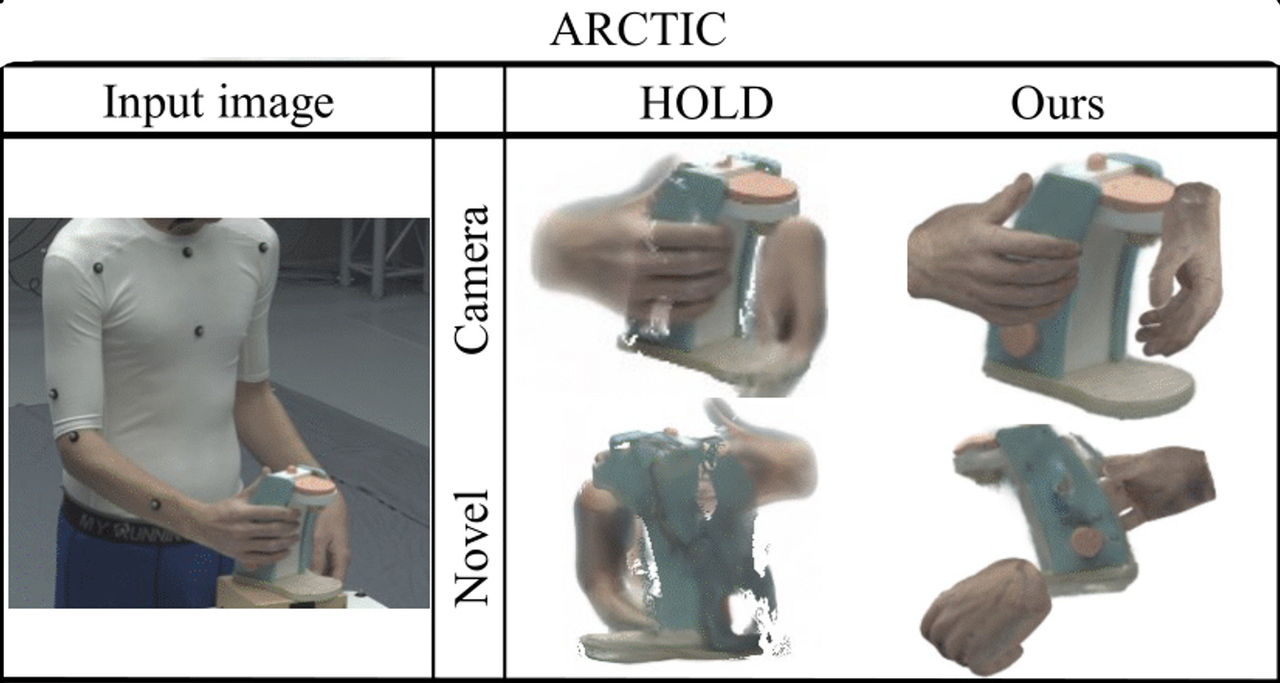

| UNIST 연구진이 개발한 ‘BIGS’ 기법으로 손-물체 상호작용을 복원한 결과, 실제 카메라 시점(Camera view)에서뿐만 아니라 보이지 않는 새로운 시점(Novel view)에서도 손과 물체의 형상을 안정적으로 예측해냈다. [UNIST 제공] |

실제 ARCTIC, HO3Dv3 등 국제 데이터셋을 활용해 실험한 결과, BIGS는 손의 자세, 물체의 형상, 두 손과 물체 간의 접촉 정보 복원은 물론 화면을 재현하는 렌더링 품질면에서도 기존 기술보다 우수한 성능을 보였다.

이번 연구는 과학기술정보통신부 한국연구재단, 정보통신기획평가원의 지원을 받아 이뤄졌으며, UNIST 온정완 연구원이 제1저자로 곽경환·강근영·차준욱·황수현·황혜인 연구원이 공동 연구자로 참여했다. 연구 결과는 11일부터 5일 동안 미국에서 열리는 컴퓨터 비전 분야 세계적 학회인 ‘CVPR(Conference on Computer Vision and Pattern Recognition) 2025’에 채택됐다

백승렬 교수는 “이번 연구는 향후 가상현실, 증강현실, 로봇 제어 등 다양한 분야에서 실시간 상호작용 복원 기술로 활용할 수 있다”고 설명했다.